Après le lancement en demi-teinte du Vision Pro (et la réduction drastique de ses objectifs de production), Apple réoriente ses ambitions de réalité augmentée vers un format beaucoup plus familier de notre secteur : les lunettes.

Selon des informations de Bloomberg, Apple accélère le développement de plusieurs appareils « wearables » boostés à l'IA, avec les lunettes connectées en fer de lance.

Le projet « N50 » pour concurrencer Meta

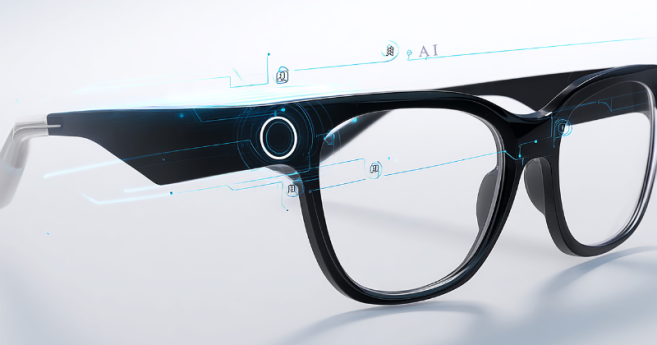

Le marché des lunettes connectées, dynamisé par le succès des Ray-Ban Meta, ne laisse pas Apple indifférent. Sous le nom de code N50, la marque à la pomme préparerait une monture sans écran qui privilégie la légèreté et l'esthétique aux technologies d'affichage complexes et énergivores.

L'interface de ce modèle reposerait sur :

- Un duo de caméras, l’une dédiée à la capture de photos et vidéos haute résolution, l’autre héritée du Vision Pro pour l’analyse de l’environnement.

- Des haut-parleurs et micros intégrés pour piloter l'assistant Siri remanié à l'aide de l'IA.

L’objectif est d'offrir au porteur un compagnon IA capable d’interpréter le monde réel : lire un menu et traduire du texte, identifier des monuments ou ajouter un rendez-vous au calendrier simplement en regardant une affiche... Des fonctionnalités que l'on retrouve dans les lunettes connectées déjà commercialisées aujourd'hui.

La production pourrait débuter en décembre 2026 pour une commercialisation courant 2027.

Après avoir exploré des partenariats avec des acteurs de l'optique traditionnelle, Apple aurait finalement choisi de concevoir ses propres montures, selon les rumeurs. Une stratégie qui diffère de ses concurrents qui travaillent tous avec des lunetiers (Meta et EssilorLuxottica, Google et Warby Parker...).

Vers une miniaturisation du suivi oculaire

En parallèle, un brevet récemment déposé par Apple confirme sa volonté de s'éloigner des casques volumineux. Le document décrit un système de suivi oculaire (eye-tracking) à une seule caméra, conçu pour des lunettes XR (réalité augmentée) beaucoup plus fines.

Pour préserver l'autonomie, Apple segmente le calcul : un « check-up » complet de l'œil est effectué par intermittence (basse fréquence), tandis qu'un algorithme léger suit les mouvements rapides en temps réel (haute fréquence). Cette astuce logicielle permet d'obtenir une grande précision sans la consommation d'énergie ni la chauffe d'un processeur classique, une condition sine qua non pour des lunettes légères et esthétiques.

Des « yeux » pour ceux qui ne portent pas de lunettes

Apple n'oublie pas les consommateurs n'ayant pas besoin de correction visuelle ou réticents au port de lunettes. Deux autres produits sont à l'étude pour intégrer l'IA dans le quotidien.

Le pendentif intelligent : de la taille d'un AirTag, ce petit boîtier pourrait se clipser sur un vêtement ou se porter en collier.

Équipé d'une caméra et d'un micro, il servirait « d'yeux et d'oreilles » à l'iPhone, capturant le contexte visuel pour alimenter l'assistant Siri. Le modèle d'Apple resterait purement un accessoire dépendant de l'iPhone.

Des AirPods avec capteurs visuels : les futurs AirPods pourraient également intégrer des capteurs (potentiellement des caméras infrarouges).

L'idée n'est pas de filmer, mais de donner à l'IA une compréhension spatiale de l'utilisateur pour améliorer les fonctions de navigation ou d'interaction avec l'environnement.

![[Vidéo] Reportage sur les opticiens en Ehpad : une expérimentation prometteuse face au vieillissement de la population](https://www.acuite.fr/sites/acuite.fr/files/styles/home_slider_video/public/articles/reportage_refraction_ehpad_opticien_lunettes_senior.png?itok=885hmxLm)

![[Vidéo] Les Ray-Ban Meta, une solution pour les déficients visuels ? Nous avons testé](https://www.acuite.fr/sites/acuite.fr/files/styles/home_slider_video/public/articles/test_rb_meta_mavoyant.png?itok=PQG6A-HL)